![]()

다들 설 연휴 잘 보내셨나요? 필자는 정신없는 연휴를 보내고 왔습니다. 할머니의 고봉밥을 몇 그릇씩 먹고, 에너자이저 사촌 동생들을 하루종일 놀아주고 나니 벌써 연휴가 끝나있네요😂 집에 돌아와서 녹다운하고 있을 때 혼공학습단의 존재가 갑자기 머릿속을 휙 하고 지나갔습니다. 아차! 싶었네요ㅎㅎ 이번주 학습을 할까 말까 수백 번은 고민한 것 같은데 그래도 기왕 시작한 거, 완주는 해야지 싶어 노트북을 켰습니다. 그럼, 마지막 혼공학습단 미션 시작해보겠습니다!! Ch 07-1. 인공 신경망 ✔️ 실습 1) 데이터 준비: 패션 MNIST 데이터셋 사용 - TensorFlow 사용 0 1 2 3 4 5 6 7 8 9 티셔츠 바지 스웨터 드레스 코트 샌달 셔츠 스니커즈 가방 앵글 부츠 2) 로지스틱 회귀로 패션 아..

![]()

혼공학습단의 완주를 2024년 시작의 목표로 잡았던 날이 엊그제 같은데 벌써 2월이네요... 시간은 정말 빠릅니다. 이번 주에는 오랜만에 여유를 되찾았습니다. 그런데 늦잠이라는 요 녀석이 안와야 할 때는 오더니만 와도 될 때는 안 오는... 참 청개구리 같은 녀석입니다.🐸🐸 뭐 암튼 2월에도 다들 열심히 공부하고 보람차게, 보내보자구요!! Ch 06-1. 군집 알고리즘 ✔️ 비지도 학습(unsupervised learning) : 타깃이 없을 때 사용하는 머신러닝 알고리즘 ✔️ 실습 1) 데이터 준비 imshow(): 넘파이 배열로 저장된 이미지를 그릴 수 있음. matplotlib 내장 함수 흑백 이미지 → cmap 매개변수를 'gray'로 지정 ⇒ 관심 대상에 집중하기 위해 배경과 대상을 반전시킴(=..

![]()

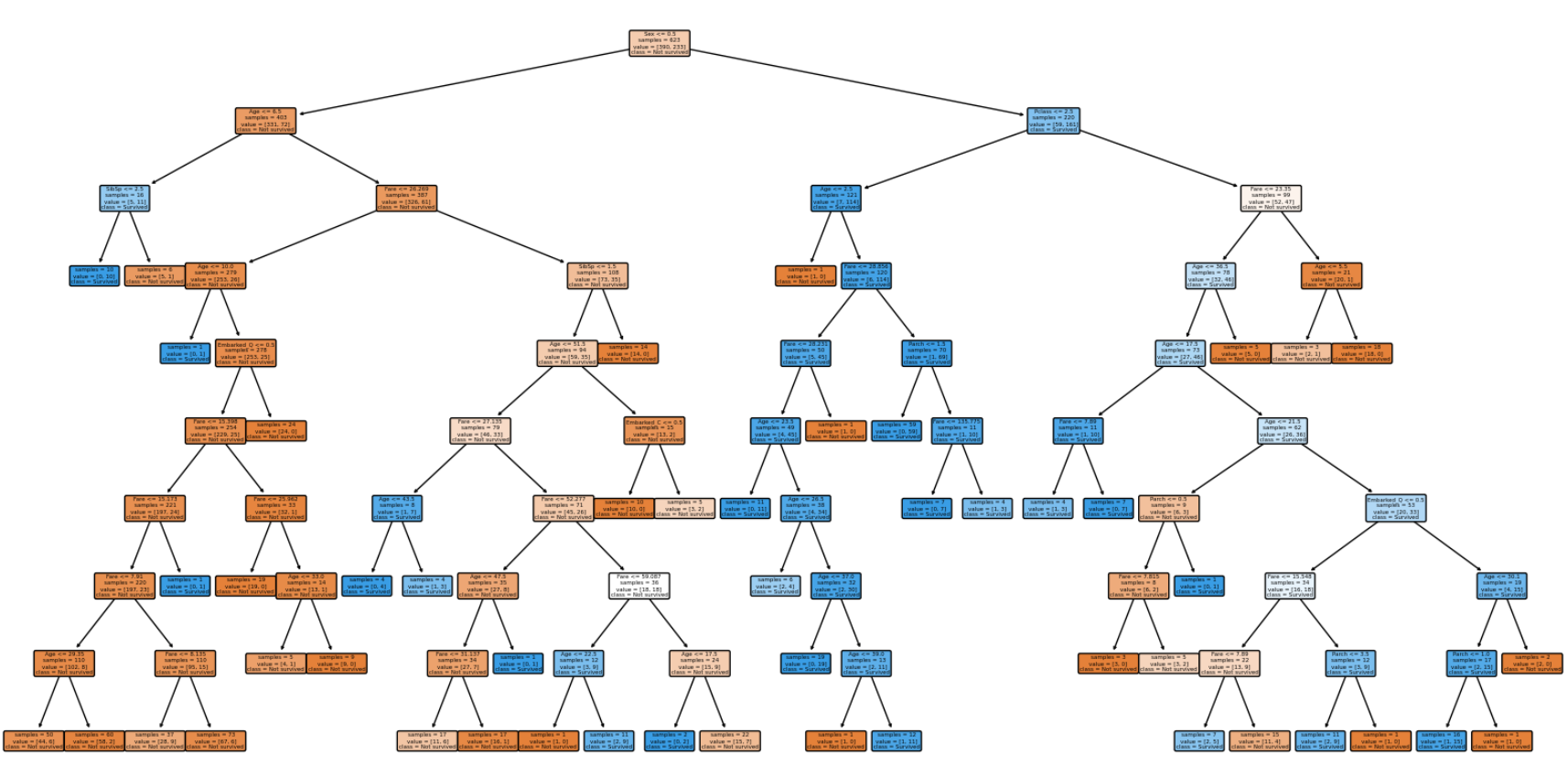

사설을 한번 시작하고 나니 멈출 수가 없습니다. 그렇지만 이것도 혼공단의 매력 아닐까 생각해 봅니다. 이번주는 정말 제 인생 그 어느 때보다 바빴다고 말할 수 있을 만큼 정신도 없고, 보람차기도 하고 피곤하기도 한 아무튼 그런 복잡한 한 주였는데 그 마무리를 혼공머신으로 할 수 있다니 감회가 남다릅니다. 트리 알고리즘, 결정 트리, Decision Tree 등 다양한 명칭으로 불리고 있는 이 알고리즘은 제가 전공 수업 때 직접 구현을 해본 모델이기도 합니다. 그래서 그런가요, 더 반가운 마음이 드네요. 바로 밑에 제가 구현했던 코드도 첨부해 놓았으니까요, 지루해질 때쯤 한번 구경해 보세요! 트리 알고리즘을 처음 구현하신 분들이라면 누구나 공감할 수 있는 웃픈 부분도 있으니까요🤣 그럼, 본격적으로 시작해 ..

![]()

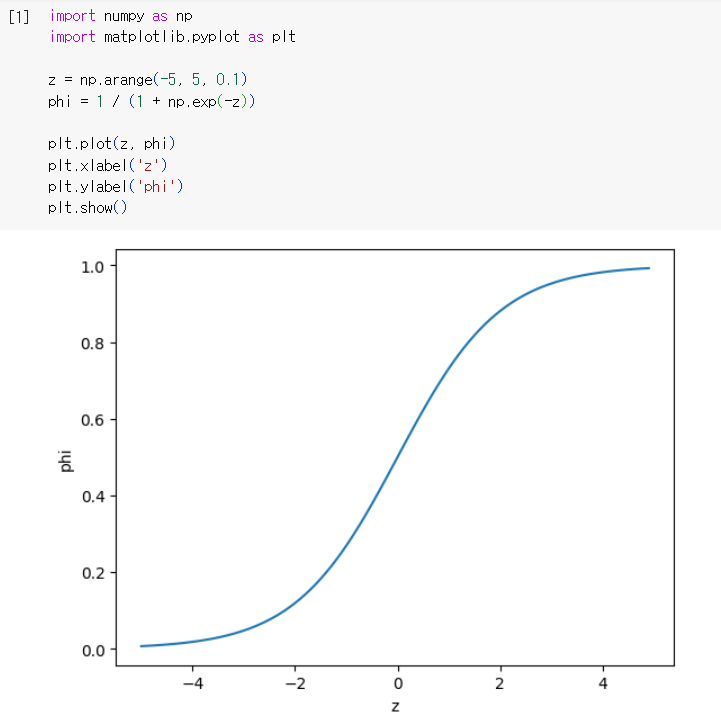

무언가를 꾸준히 한다는 게 참 쉽지 않다는 걸 느끼고 있습니다. 왜 변환점을 도는 요맘때가 고비인 지 알 것 같아요 평일에 혼공단 활동을 하는 게 쉽지 않아서 주말에 하고 있는데 정말 하루하루가 순식간에 지나갑니다. 사설이 길어지는 3주차입니다..ㅎㅎ 진짜 그러면 시작해 볼까요!!! Ch 04-1. 로지스틱 회귀 ✔️ 로지스틱 회귀 : 선형 방정식을 바탕으로 분류를 하는 모델 시그모이드 함수를 이용하여 0~1 사이 값을 표현 - 넘파이를 이용하여 시그모이드 함수 그래프를 그리면 다음과 같다. ✔️ 로지스틱 회귀 이진 분류 실습 1) 데이터 준비 2) 모델 학습 3) 샘플 예측 및 예측 확률 출력 4) 사용된 로지스틱 회귀 함수 확인 따라서, 로지스틱 회귀 모델이 학습한 방정식은 다음과 같음 z = -0...

![]()

Ch 03-1. k-최근접 이웃 회귀 ✔️ 회귀 : 임의의 어떤 숫자를 예측하는 문제. 정해진 클래스가 없고 임의의 수치를 출력 ex) 내년도 경제 성장률 예측, 배달이 도착할 시간 예측 ✔️ k-최근접 이웃 회귀 : 분류와 똑같이 예측하려는 샘플에 가장 가까운 샘플 k개를 선택, k개의 평균값이 샘플의 예측 타깃값 : 이웃한 샘플의 타깃은 임의의 수치(not 클래스) ✔️ 교재 실습 1) 데이터 준비 및 시각화 2) 회귀 모델 훈련 및 평가 결정계수($R^2$) : 각 샘플의 타깃과 예측한 값의 차이를 곱하여 더하고, 타깃과 타깃 평균의 차이를 제곱하여 더한 값으로 나눔 : 타깃의 평균 정도를 예측하는 수준이라면 $R^2$는 0에 가까워지고 예측이 타깃에 아주 가까워지면 1에 가까운 값이 됨 MAE(M..